大數據處理中的數據提取 關鍵概念與技術詳解

在當今信息爆炸的時代,大數據處理已成為挖掘數據價值、驅動決策的核心環節。其中,數據提取作為整個數據處理流程的起點和基石,扮演著至關重要的角色。它是指從多種異構、分散的數據源中識別、收集和初步篩選出相關數據的過程,為后續的存儲、清洗、分析和應用奠定基礎。本文將深入解析大數據處理中數據提取的關鍵概念。

一、 數據提取的核心定義與目標

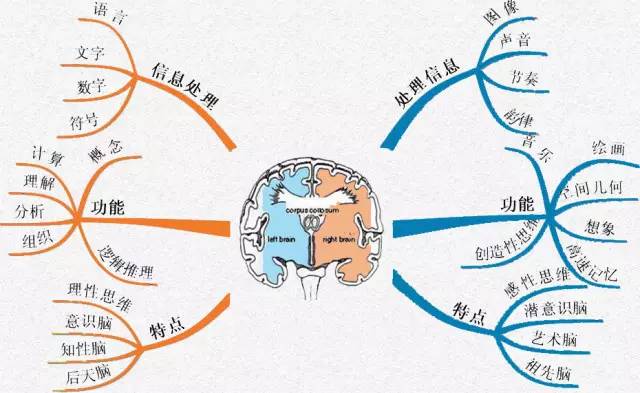

數據提取,有時也稱作數據采集或數據獲取,其核心目標是從一個或多個源頭系統地獲取數據,并將其轉換為能夠被后續系統處理和存儲的格式。這些數據源可能包括:

1. 結構化數據源:如關系型數據庫(MySQL, Oracle)、數據倉庫中的表格。

2. 半結構化數據源:如JSON、XML文件、網頁、日志文件。

3. 非結構化數據源:如文本文檔、圖片、音頻、視頻。

4. 流數據源:如傳感器實時數據、社交媒體信息流、在線交易記錄。

其最終目的是構建一個統一、可靠的數據入口,確保下游分析所依賴的數據的完整性、準確性和時效性。

二、 關鍵概念詳解

1. 數據源連接與適配

這是數據提取的第一步。關鍵技術包括使用API接口(如RESTful API)、數據庫連接器(JDBC/ODBC)、網絡爬蟲、文件系統監聽以及消息隊列(如Kafka)等。適配器需要處理不同數據源的協議、認證和數據結構差異。

- 增量提取與全量提取

- 全量提取:首次或定期完整拷貝源數據。優點是實現簡單,缺點是資源消耗大,對源系統壓力大。

- 增量提取:僅捕獲自上次提取以來發生變化的數據。關鍵技術包括基于時間戳、變更數據捕獲(CDC)和日志跟蹤等。它能顯著提高效率,降低負載,是實現實時或近實時數據處理的基礎。

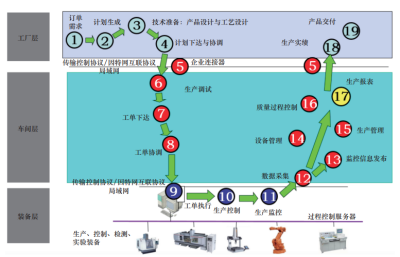

3. ETL 與 ELT 流程中的“E”

在傳統ETL(提取、轉換、加載)中,數據在提取后通常會在專門的ETL服務器中進行轉換,再加載到目標倉庫。而在現代ELT(提取、加載、轉換)模式中,數據被快速提取并原始地加載到高性能存儲(如數據湖)中,轉換工作在存儲層后續進行。數據提取的策略需根據整體架構選擇進行調整。

4. 數據抓取與爬取

針對網頁等公開數據源,需要使用網絡爬蟲技術。這涉及頁面下載、HTML解析、反爬蟲策略應對(如遵守robots協議、設置合理間隔)以及動態內容的處理(如通過無頭瀏覽器執行JavaScript)。

5. 流式數據提取

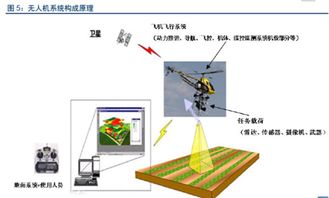

對于持續生成的數據流,提取過程必須是持續和低延遲的。這通常借助流處理框架(如Apache Flume, Apache NiFi, Spark Streaming)實現,它們能夠實時攝取數據并將其導入流處理管道或存儲系統。

6. 數據質量與元數據管理

在提取階段就需關注數據質量。這包括記錄數據來源、提取時間、數據格式等元數據,并進行初步的完整性檢查(如關鍵字段是否缺失)和基礎的一致性驗證(如數據類型是否符合預期)。良好的元數據管理是數據可追溯性和可信度的保障。

7. 容錯與可恢復性

大規模數據提取必須設計容錯機制,處理網絡中斷、源系統不可用等異常。常見策略包括斷點續傳、失敗重試、告警監控等,確保提取作業的魯棒性。

三、 技術挑戰與發展趨勢

挑戰主要包括:處理海量、高維、高速數據帶來的性能壓力;保障多源異構數據提取的一致性;應對源系統結構變更的適應性;以及在合規框架(如GDPR)下進行安全、合規的數據提取。

未來趨勢體現在:

- 自動化與智能化:利用AI自動識別數據源模式、推薦提取策略、檢測數據異常。

- 實時化:隨著物聯網和在線業務發展,對實時數據提取與處理的需求日益增長。

- 云原生與Serverless:基于云平臺的數據提取服務(如AWS Glue, Azure Data Factory)提供了托管、可擴展的解決方案,降低了運維復雜度。

數據提取遠非簡單的數據搬運。它是一個融合了連接技術、增量策略、質量控制和容錯設計的復雜過程。深入理解并優化數據提取環節,是構建高效、可靠大數據處理管道,最終實現數據價值最大化的關鍵第一步。

如若轉載,請注明出處:http://www.sandukongjian.cn/product/76.html

更新時間:2026-02-09 02:16:23