Python爬蟲與信息處理

Python爬蟲與信息處理是當今數據驅動時代中至關重要的技術組合。通過Python編寫的網絡爬蟲,可以高效地從互聯網上采集大量數據,而信息處理技術則能對這些原始數據進行清洗、整理和分析,從而提取出有價值的信息。以下將分兩部分詳細介紹這兩項技術及其應用。

一、Python爬蟲技術

Python爬蟲是指利用Python編程語言及相關庫(如requests、BeautifulSoup、Scrapy等)自動抓取互聯網上公開信息的技術。其核心步驟包括:發送HTTP請求獲取網頁內容、解析HTML結構提取目標數據,以及存儲數據(如保存到文件或數據庫)。Python爬蟲的優勢在于其簡潔的語法和豐富的第三方庫支持,使得開發者能夠快速構建高效、可擴展的爬蟲程序。常見應用場景包括:市場調研(抓取競爭對手價格)、新聞聚合(收集多個媒體頭條)、學術研究(采集論文數據)等。使用爬蟲時需遵守相關法律法規和網站robots.txt協議,避免過度請求導致服務器壓力。

二、信息處理技術

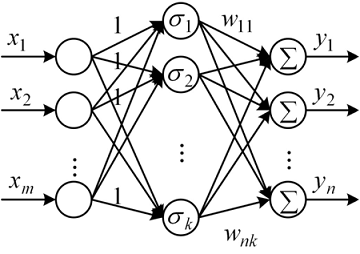

信息處理是指對采集到的原始數據(如文本、圖片、視頻等)進行清洗、轉換、分析和可視化的過程。Python在這方面同樣表現出色,常用庫如Pandas用于數據清洗和處理、NumPy和SciPy用于科學計算、NLTK和spaCy用于自然語言處理、以及Matplotlib和Seaborn用于數據可視化。信息處理的關鍵步驟包括:數據預處理(去除噪聲、處理缺失值)、特征提取(從數據中識別關鍵屬性)、數據分析和建模(應用統計或機器學習方法發現模式)。例如,在電商領域,可通過信息處理技術分析用戶評論的情感傾向,以優化產品策略;在金融領域,可處理交易數據以檢測異常行為。

三、Python爬蟲與信息處理的結合

在實際應用中,Python爬蟲和信息處理往往是相輔相成的。爬蟲負責數據的采集,而信息處理則賦予數據意義。例如,構建一個輿情監控系統:首先使用爬蟲抓取社交媒體上的帖子,然后通過信息處理技術進行情感分析、主題分類和趨勢預測,最終生成可視化報告。這種結合不僅提高了數據獲取的效率,還增強了決策的準確性。對于初學者,建議從基礎庫如requests和Pandas入手,逐步掌握爬蟲框架(如Scrapy)和高級分析工具(如Scikit-learn)。注意數據隱私和倫理問題,確保技術應用的合規性。

Python爬蟲與信息處理是現代數據科學的核心技能,它們幫助我們從海量網絡信息中挖掘洞見,推動業務創新和社會發展。通過持續學習和實踐,開發者可以構建強大的數據管道,解決現實世界中的復雜問題。

如若轉載,請注明出處:http://www.sandukongjian.cn/product/49.html

更新時間:2026-02-09 13:29:43